نحوه بهینهسازی فایل Robots.txt در وردپرس

راههای بسیار گوناگونی برای بهینهسازی وبسایت وجود دارد. یکی از این روشهای مهم، استفاده از فایل robots.txt به عنوان ابزار بسیار قدرتمندی برای سئو میتوان نام برد. در این مقاله، ما به نحوهی ایجاد یک فایل بهینهسازی شده robots.txt برای برخورداری از سئو بهتر میپردازیم.

فایل Robots.txt چیست؟

فایل robots.txt یک فایل متنی ساده است که به خزندهها و رباتهای گوگل فرمان میدهد که به چه نحوی وبسایت را مشاهده و در موتور جستجو ثبت و ایندکس کنند. این فایل معمولاً در مسیر روت یا همان فولدر اصلی که محتویات وبسایت در آن قرار دارد، آپلود میشود. مسیر روت در هاستهای سیپنلی File Manager > Public_html است. فرمت اصلی فایل robots.txt به صورت زیر است:

User-agent: [user-agent name] Disallow: [URL string not to be crawled] User-agent: [user-agent name] Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap]

در محتویات این فایل میتوانید در خطوط مختلف از دستورهای allow یعنی اجازه بده و disallow یعنی اجازه نده استفاده کنید. در واقع در این خطوط شما به رباتهای گوگل میگویید که اجازه داری این بخش از وبسایت را که صفحهای مربوط به فلان بخش است ایندکس کنی و یا اجازه نداری آن صفحه را خزش و ایندکس کنی. علاوه بر URL یا همان آدرس صفحه و پست میتوانید آدرس فایل Sitemap نیز قرار دهید.

یک نمونهی واقعی از این فایل به صورت زیر است:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml

در مثال فوق در خط دوم ما به خزندههای گوگل اجازه دادیم که حتی مسیر پوشهی Uploads در وردپرس را ایندکس کنند.

پس از آن به رباتهای گوگل دستور دادیم تا از مشاهده و ایندکس پلاگینهای وردپرس و بخش ادمین آن پرهیز کنند.

در آخر نیز URL مربوط به XML Sitemap وبسایت را تعریف کردیم.

آیا واقعاً به فایل Robots.txt در سایت وردپرسیتان نیاز دارید؟

اگر وبسایت شما دارای فایل robots.txt نباشد، باز هم موتورهای جستجو وبسایت شما را خزش و ایندکس میکنند. گرچه دیگر امکانش را ندارد که به رباتها بگویید کدام صفحات و پوشهها بررسی و ایندکس نشوند.

شاید اثر آن در ابتدای امر یعنی زمانی که به تازگی بلاگ خود را آغاز کردهاید و محتوای بسیاری ندارید، زیاد نباشد اما از زمانی که وبسایتتان رشد کرد و محتوای بسیاری درون آن قرار گرفت بهتر است کنترل بیشتری و هدفمندتری بر روی نحوه ایندکس وبسایتتان داشته باشید.

دلیل اصلیاش این است:

رباتهای موتورهای جستجو دارای سهمیه مشخص برای خزش هر وبسایت هستند.

این بدین معناست که رباتها در هر مرتبه یا جلسه که خزش را انجام میدهند، از تعداد مشخصی صفحه بازدید میکنند. اگر آنها کار خزش تمامی صفحات وبسایت شما را تمام نکنند، مرتبهی بعدی که برای خزش بازگشتند، ادامهی کار قبلی خود را ازسرگیری خواهند کرد.

مقاله مرتبط: راهنمای گام به گام Robots.Txt

نتیجهی این خزش صفحههای بیشتر غیر مورد نیاز، کاهش میزان ایندکس بخشهای مختلف وبسایت شما است.

این مشکل را میتوانید به سادگی با عدم صدور مجوز و جلوگیری از خزش صفحات غیر ضروری یعنی صفحات ادمین وردپرس، فایلهای مربوط به افزونهها و فولدر پوستهها رفع کنید.

با اجازهی خزش صفحات غیر ضروری ندادن به رباتها میتوانید سهمیه خزش خود را ذخیره کنید. این کار میکند تا موتورهای جستجو صفحات بیشتری از وبسایت شما را خزش کنند و ایندکس آنها بسیار سریعتر اتفاق افتد.

فایدهی دیگر استفاده از فایل robots.txt این است که بهوسیلهی آن قادر خواهید بود از ایندکس نوشته یا صفحهای خاص در وبسایت خود جلوگیری کنید. این کار ایمنترین روش برای پنهان کردن محتوا از دید عموم نیست اما با این وجود به شما کمک میکند تا از دسترسی به آن ظاهر شدنش در موتورهای جستجو جلوگیری کنید.

یک فایل ایده آل Robots.txt باید چه شکلی باشد؟

بسیاری از وبلاگهای معروف از یک فایل بسیار ساده به عنوان فایل robots.txt خود استفاده میکنند. البته محتوای آن ممکن است با توجه به نیاز خاص آن وبسایت متفاوت باشد:

User-agent: * Disallow: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

این فایل robots.txt به رباتها اجازه میدهد تا تمامی محتوا را ایندکس کنند و همچنین به آنها لینک و مسیر سایت مپ وبسایت را ارائه میدهد.

برای وبسایتهای وردپرسی، پیشنهاد ما استفاده از دستورهای زیر در فایل robots.txt است:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Disallow: /readme.html Disallow: /refer/ Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

این دستورها به رباتهای جستجو اجازه میدهد تا تمامی تصاویر و فایلهای موجود در وردپرس را ایندکس کنند. از طرفی به رباتهای جستجوگر اجازه ایندکس فایلهای مربوط به پلاگینهای وردپرس، بخش داشبورد و فایلهای ادمین وردپرس، فایل readme وردپرس و لینکهای Affiliate یا همکاری در فروش را نمیدهد.

با افزودن Sitemap به فایل robots.txt، پیدا کردن تمامی صفحات اصلی در وبسایت را برای رباتهای گوگل آسان خواهید کرد.

حال که با محتوای یک فایل ایده آل robots.txt آشنا شدید، بیایید نگاهی به نحوهی ایجاد فایل robots.txt در وردپرس بی اندازیم.

چگونه یک فایل Robots.txt در وردپرس ایجاد کنیم؟

دو روش جهت ایجاد فایل robots.txt در وردپرس وجود دارد که میتوانید از بین آنها یکی را انتخاب کنید:

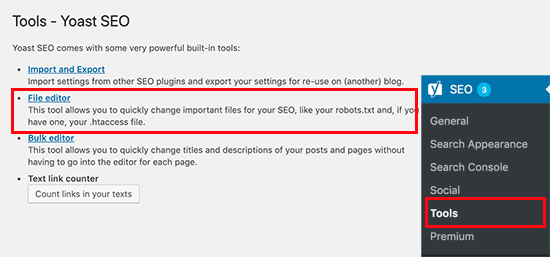

روش اول: ویرایش فایل Robots.txt با استفاده از افزونه Yoast SEO

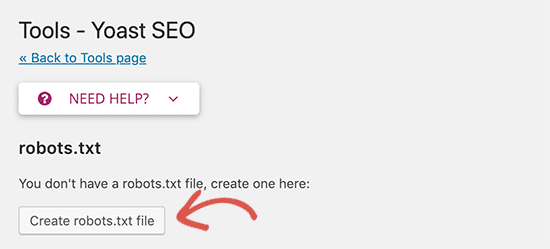

چنانچه از افزونه Yoast SEO استفاده میکنید، بهراحتی میتوانید از قابلیت ایجاد فایل robots.txt در آن استفاده کنید.

جهت ایجاد و ویرایش فایل robots.txt مد نظر خود کافی است به بخش داشبورد وردپرس خود مراجعه کنید. سپس با مراجعه به صفحه SEO > Tools در پنل ادمین وردپرس خود، بر روی گزینهی File Editor کلیک کنید.

در صفحهی بعد، پلاگین Yoast SEO به شما فایل robots.txt از پیش موجود را نمایش میدهد.

چنانچه از قبل دارای فایل robots.txt نیستید، Yoast SEO برای شما بک فایل robots.txt ایجاد میکند. در واقع دکمهای با عنوان Create robots.txt file به شما نمایش میدهد. کافی است بر روی آن کلیک کنید.

به صورت پیشفرض، Yoast SEO فایل robots.txt با محتوای زیر را برای شما ایجاد میکند:

User-agent: *

Disallow: /

بسیار مهم است که محتوای این فایل را پس از ایجاد حذف کنید؛ چراکه محتوای فوق تمامی موتورهای جستجو را از مشاهده و خزش وبسایتتان منع میکند.

مقاله مرتبط: چگونه نقشه سایت را به فایل Robots.txt اضافه کنیم؟

پس از حذف محتوای پیشفرض، میتوانید فرمانهای فایل robots.txt مدنظر خود را در این فایل قرار دهید. پیشنهاد ما این است که از همان محتوای ایده آل robots.txt که در بالا با شما به اشتراک گذاشته شد، استفاده کنید.

پس از اتمام فراموش نکنید که بر روی گزینهی «Save robots.txt» کلیک کنید تا تغییرات ایجاد شده اعمال شود.

روش دوم: ویرایش فایل robots.txt بهصورت دستی با استفاده از FTP

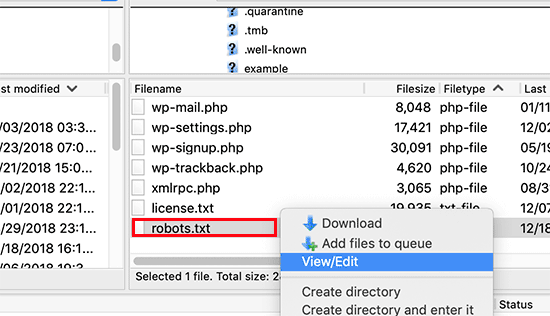

در این روش باید از FTP کلاینت برای ویرایش فایل robots.txt استفاده کنید. بهمنظور این کار، به حساب هاست وردپرس خود وارد شوید و از FTP استفاده کنید.

زمانی که وارد شدید، فایل robots.txt در پوشه روت سایت قابل مشاهده خواهد بود.

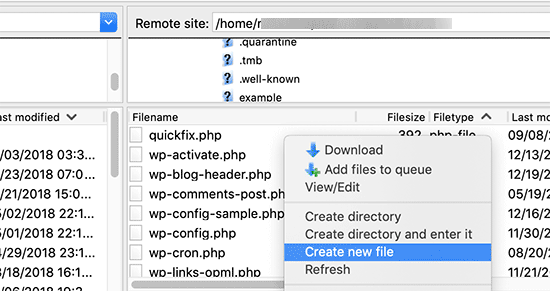

اگر در این بخش نتوانستید فایل robots.txt خود را بیابید، به این معنی است که سایت شما فاقد این فایل است. پس برای ایجاد آن طبق تصویر زیر، اقدام کنید.

Robots.txt یک فایل با متن ساده است که برای ایجاد هرگونه تغییر در آن، میتوانید آن را در سیستم خود دانلود نموده و با استفاده از هر نوع ویرایشگر متن از جمله Notepad یا TextEdit تغییرات مورد نظر خود را اعمال کنید.

چگونه فایل Robots.txt خود را تست کنیم؟

پس از ایجاد یک فایل جدید برای robots.txt، بهتر است که پیش از اعمال هرگونه تغییر، آن را با یک ابزار مناسب تست کنید.

ابزارهای زیادی برای تست این فایل وجود دارند؛ اما ما ابزاری را که در گوگل سرچ کنسول به منظور این کار تعبیه شدهاست، پیشنهاد میکنیم.

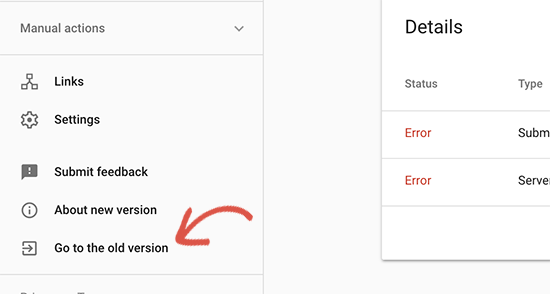

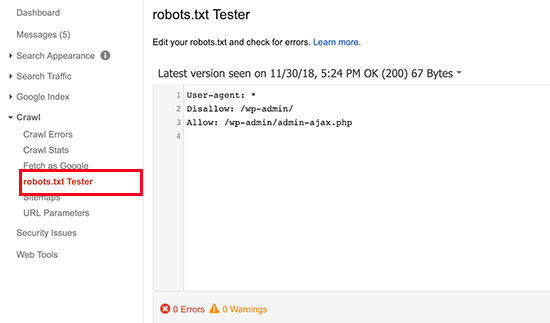

برای انجام این کار، به اکانت گوگل سرچ کنسول خود لاگین کنید و سپس نسخه قدیمی آن را انتخاب نمایید.

با انتخاب نسخه قدیمی گوگل سرچ کنسول، تنظیمات و منو قدیمی نیز برای شما به نمایش در خواهد آمد. در این مرحله، ابزار تست کننده فایل robots.txt را از زیر منو «Crawl» انتخاب کنید.

این ابزار به صورت خودکار، فایل robots.txt شما را بررسی و آزمایش کرده و لیست خطاهای موجود را در اختیار شما قرار خواهد داد.

منظور از بهینه کردن فایل robots.txt، این است که مرورگرها را از بررسی برخی از صفحات سایت منع کنیم، از جمله صفحاتی که در دسترس نیستند مانند صفحات موجود در پوشه پلاگینها یا صفحات پوشه ادمین وردپرس.

با استفاده از نکات بررسی شده در این مقاله، قادر خواهید بود تا فایل robot.txt سایت خود را به منظور بهبود سئو، بهینه نمایید.